数据治理 数据处理的基石与导航

在数字化浪潮席卷全球的今天,数据已成为驱动企业决策、优化运营、创新服务的核心资产。原始数据如同未经雕琢的璞玉,其价值的真正释放,离不开一套科学、系统且贯穿始终的流程——数据处理。这不仅是技术层面的操作,更是数据治理宏大框架中至关重要的一环,它决定了数据的质量、可用性与安全性,是数据能否转化为有效信息和智慧的关键。

数据处理,广义上涵盖了从数据产生到最终被分析利用的全生命周期活动,主要包括数据收集、清洗、整合、存储、加工、分析、可视化及销毁等多个阶段。在数据治理的视角下,这些活动并非孤立的技术任务,而是需要置于统一的策略、标准与规范之下进行。

1. 数据收集与获取:治理的起点

数据处理的源头是收集。数据治理首先要求明确数据的来源、采集方式、频率及权限。这涉及到数据确权与合规性,例如在收集用户数据时必须遵循如GDPR、个人信息保护法等法规,确保数据来源合法、正当、必要。治理框架会定义哪些数据是业务所需的“关键数据资产”,避免无目的的数据囤积,从源头控制数据质量与成本。

2. 数据清洗与标准化:质量的守护者

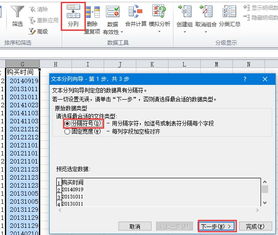

收集到的原始数据往往存在缺失、错误、不一致、重复等问题。数据清洗是数据处理中繁重但不可或缺的一步。数据治理为此设立质量标准和质量规则,例如定义唯一标识符、规范日期格式、统一计量单位、识别并处理异常值等。通过建立标准化的清洗流程和规则库,确保进入下游的数据是准确、一致、可靠的,为后续分析奠定可信基础。

3. 数据整合与存储:一致性的架构

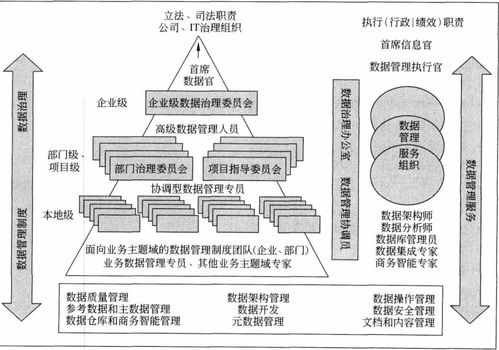

企业数据常散落在不同系统、部门,形成“数据孤岛”。数据处理中的整合阶段,旨在将这些异构数据关联、合并,形成统一的视图。数据治理在此环节提供主数据管理、元数据管理策略。例如,确保“客户”在主数据系统中具有唯一、准确的定义,并被所有业务系统一致引用。治理策略也指导数据的存储架构(如数据湖、数据仓库)、存储周期、安全分级和访问控制,平衡数据可用性、安全性与成本。

4. 数据加工与分析:价值的提炼场

数据经过清洗整合后,通过计算、建模、分析等加工过程转化为信息与洞察。数据治理确保这一过程的可追溯与可重复。例如,通过管理分析模型、算法及其版本,记录数据血缘关系(即数据从源头到最终报表的完整转换路径),使得分析结果可信、可审计。治理也关注分析过程中的数据安全,防止敏感信息在分析中泄露。

5. 数据服务与销毁:闭环的控制

处理后的数据最终需要以报表、API、数据产品等形式服务于业务。数据治理定义了数据服务的目录、访问权限和SLA(服务水平协议),确保数据被安全、合规地消费。另一方面,对于不再需要或超过保留期限的数据,治理政策要求安全、彻底的销毁,以降低存储成本和管理风险,并满足隐私法规的“被遗忘权”要求。

贯穿始终的核心:元数据与数据质量

在数据处理的每一个环节,元数据(关于数据的数据,如业务含义、技术格式、负责人等)都如同数据的“身份证”和“说明书”,是理解、管理和使用数据的基础。数据治理通过建立元数据管理体系,实现数据处理流程的透明化和自动化。而数据质量监控则是持续的保障,通过设定质量指标并持续测量,及时发现并修复数据处理各阶段产生的质量问题。

****

数据处理绝非单纯的技术流水线,而是在数据治理战略指导下的系统性工程。强有力的数据治理为数据处理提供了政策、标准、角色和流程的框架,确保数据处理活动高效、合规、安全且能够持续产生业务价值。将数据处理置于治理之下,意味着企业能够真正驾驭数据洪流,让高质量的数据成为业务创新与稳健发展的强大引擎,而非负担或风险之源。因此,谈数据治理,必深入“数据处理那些事”;做好数据处理,也必始于健全的数据治理。

如若转载,请注明出处:http://www.smxlzj.com/product/71.html

更新时间:2026-03-03 10:43:28